Utveckla AI-funktioner

Att bygga in AI i en webbplats eller applikation öppnar för helt nya möjligheter. Det kan handla om allt från att skapa smartare sökfunktioner och personliga rekommendationer, till att analysera stora datamängder, automatisera supportflöden eller ge användarna en interaktiv assistent direkt i gränssnittet.

Utnyttja API:er

Det vanligaste sättet att komma igång är att låta en applikation kommunicera med en AI-modell via API. Din kod skickar in data (en prompt) till modellen och får tillbaka ett svar som sedan kan användas i appen.

För att detta ska fungera bra är två begrepp centrala: prompt engineering och context. Prompt engineering handlar om att formulera sin fråga eller instruktion på ett sätt som modellen förstår och ger bäst möjliga svar på. En bra prompt är ofta tydlig, avgränsad och kan innehålla exempel. Context är den extra information man skickar in tillsammans med prompten för att ge modellen rätt bakgrund. Det kan vara tidigare meddelanden i en konversation eller utdrag ur en databas som modellen behöver för att ge korrekta svar.

All text som skickas till eller genereras av modellen bryts ner i tokens. En token kan både vara ett helt ord eller en del av det, räkna med ca 4 tecken per token eller 75 ord per 100 tokens. Kostnaden för API-anrop beräknas per X tokens, både för prompten och för svaret. En kort fråga med ett längre svar kanske blir totalt 500 tokens, medan en konversation med mycket context kan bli tusentals tokens. Då kan kostnaden snabbt öka om man gör många anrop.

Utforska gärna exempel på anrop mot API:er på itiden.ai.

Etablerade AI-tjänster

De stora aktörerna som tex OpenAI, Anthropic, Mistral, xAI och Google tillhandahåller modeller via sina API:er. De skiljer sig inte bara i pris och kvalitet, utan också i vilka funktioner de stöder. Vissa modeller kan ta emot bilder som input och analysera dem tillsammans med text. Andra har stöd för att anropa externa tools direkt från API:et, eller för att köra i olika “lägen” som optimerar för snabbhet eller detaljrikedom.

Genom att välja rätt modell för rätt uppgift kan man optimera både kvalitet, kostnad och funktionalitet. Dokumentationen är oftast tydlig och det finns gott om exempel, vilket gör att dessa tjänster är det enklaste sättet att börja bygga AI-funktioner i en applikation.

Se lista på modeller och kostnader på models.dev.

Utveckla egna API:er

Ibland vill man inte vara beroende av en extern leverantör, utan bygga egna tjänster där AI integreras på det sätt som passar bäst.

Självhosta

Med verktyg som Ollama kan du köra open-source-modeller som LLaMA, Mistral eller Gemma direkt på din egen dator eller server. För att detta ska fungera krävs relativt kraftfull hårdvara. På PC-sidan innebär det ofta ett modernt NVIDIA-grafikkort med gott om VRAM, 8-12 GB räcker för mindre modeller, medan större varianter kan kräva 24 GB eller mer. På Mac fungerar Apple Silicon-chipen särskilt bra tack vare deras minnesarkitektur, där det delade RAM-minnet används som motsvarighet till VRAM. En MacBook Pro med 32 eller 64 GB RAM kan därför köra betydligt större modeller än en enklare laptop.

Fördelen med självhostat är kontroll, hög integritet och att inga löpande API-kostnader tillkommer. Nackdelen är att de allra största modellerna inte är praktiskt möjliga att köra lokalt, och att prestandan begränsas av din hårdvara.

Cloudflare AI

Med Cloudflare Workers AI kan du köra open-source-modeller som LLaMA eller Mistral utan att själv sätta upp tunga servrar. Du får tillgång till ett API som kan anpassas och integreras i dina applikationer på samma sätt som andra AI-tjänster. Med Vectorize finns en färdig vektordatabas för RAG-lösningar och med AI Gateway får du funktioner för caching, övervakning och kostnadskontroll. Lösningen gör det enkelt att bygga AI-funktioner utan att hantera hårdvara, men du är fortfarande beroende av Cloudflare som plattform för att köra och skala modellerna.

RAG – bygga appar på egen data

En språkmodell har bara tillgång till den information den tränats på vid skapandet. Den kan alltså inte känna till data som tillkommit efteråt eller sådan som aldrig varit publik, till exempel interna dokument, produktmanualer eller företagsunika databaser. Vill man att modellen ska kunna använda sådan information behöver den göras tillgänglig på ett strukturerat sätt.

Med RAG (Retrieval Augmented Generation) sparas informationen i förväg i en vektordatabas. Text delas upp i mindre delar, konverteras till vektorer och indexeras. När en fråga ställs konverteras den till en vektor och matchas mot de mest relevanta delarna i databasen. Dessa delar skickas sedan in i prompten tillsammans med frågan, så att modellen kan ge svar baserat på just din data.

Det som tidigare ofta skickades direkt som context i varje API-anrop behöver därmed inte upprepas, utan finns lagrat och kan hämtas vid behov. För bästa resultat används en kombination av vektorsökning (semantisk likhet) och nyckelordsökning (exakta träffar) i en hybridsökning.

MCP

Med Model Context Protocol (MCP) kan AI-modeller få tillgång till externa system via standardiserade “tools”. Det innebär att AI:n inte bara svarar på frågor, utan också kan agera – exempelvis hämta data, skapa eller uppdatera poster.

Utveckla och utnyttja egen MCP-server

En egen MCP-server kan byggas för att exponera de system och funktioner som är viktiga i just din applikation. Det kan vara integrationer mot databaser, interna API:er eller affärssystem.

När man skapar ett tool definieras inte bara dess namn och parametrar, utan även en beskrivning. Denna beskrivning används av AI:n för att avgöra när verktyget är relevant att anropa. Om till exempel ett tool har beskrivningen “skapar ett supportärende i företagets ärendehanteringssystem” kommer modellen, när en användare skriver “Skapa ett ärende för att inloggningen inte fungerar”, att känna igen att verktyget matchar uppgiften och använda det.

På så sätt kan AI:n använda dina verktyg som naturliga delar av konversationen, utan att du behöver hårdkoda logiken för varje enskilt fall.

Använd existerande MCP-servrar i ert projekt

Det finns redan färdiga MCP-servrar och verktyg som kan kopplas på. Genom att använda dessa kan du snabbt ge AI:n nya funktioner utan att bygga allt själv. Det kan handla om integrationer mot projekthanteringssystem eller affärssystem. Det finns även MCP-servrar som exponerar allmänna verktyg som kalkylatorer, kalenderhantering eller webbsök.

Samtidigt är det viktigt att använda MCP-tools med försiktighet. Eftersom AI:n avgör när ett verktyg ska användas, kan du oavsiktligt exponera funktioner eller data som inte borde vara åtkomliga. Var därför noga med vilka verktyg som kopplas in, och säkerställ att de bara ger åtkomst till det som faktiskt är avsett.

Genom att välja rätt MCP-servrar och sätta tydliga gränser kan du utöka AI:ns förmågor utan extra utvecklingsarbete, samtidigt som du behåller kontrollen över vad som exponeras.

Slutsatser

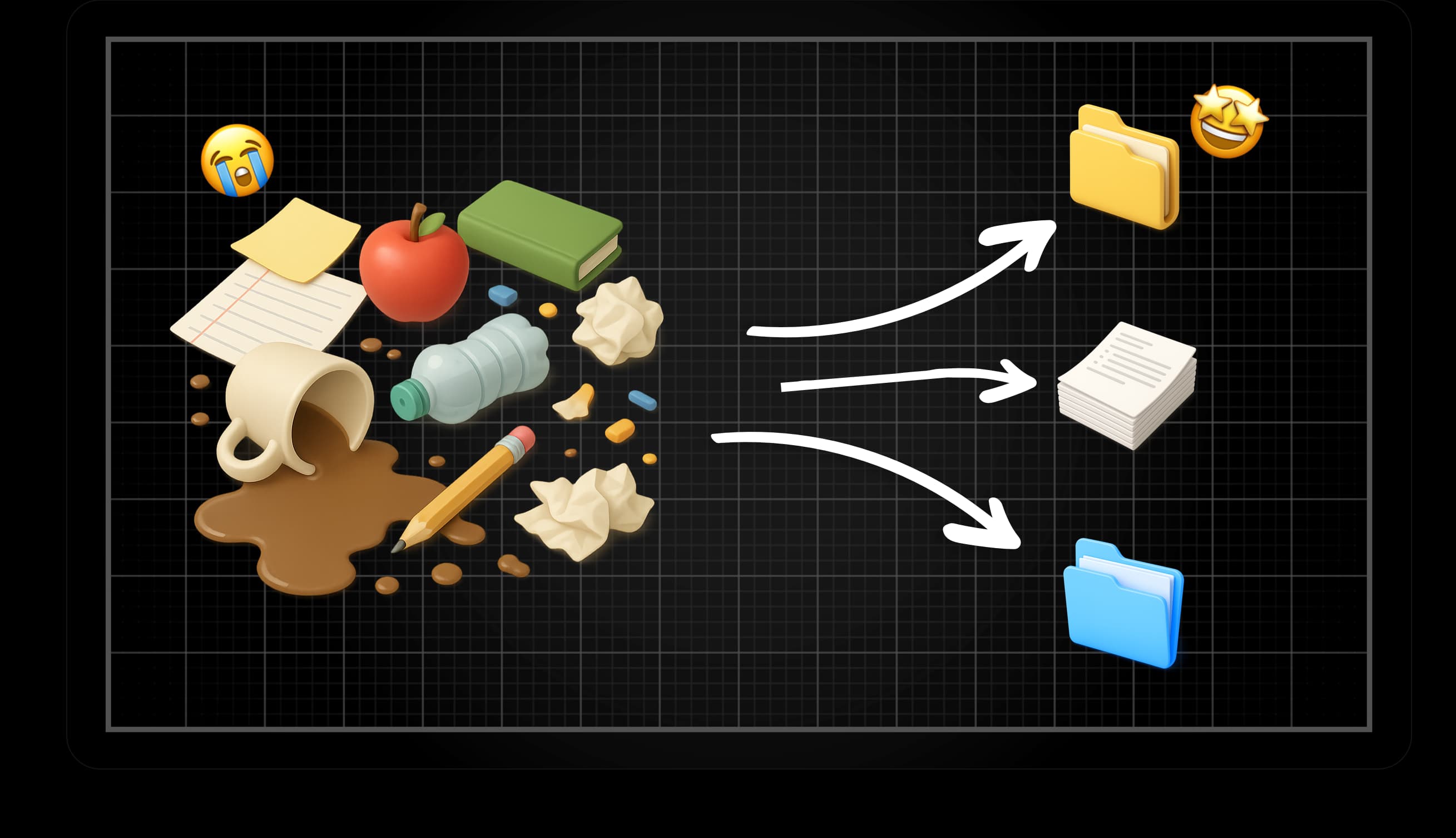

Att bygga AI i applikationer handlar om att kombinera olika byggstenar. API:er ger snabb tillgång till kraftfulla modeller, självhostade alternativ som Ollama ger integritet och kontroll, och plattformar som Cloudflare gör driften enklare. Med RAG kan AI svara utifrån din egen data och med MCP får den möjlighet att agera i dina system.

Men det finns inga färdiga recept – man behöver testa sig fram. Olika modeller kan ge olika typer av svar, och resultatet påverkas starkt av hur prompten formuleras, vilken context som skickas in och vilken modell som används. Även kostnaden måste vägas in; stora context och många anrop kan snabbt bli dyrt.

När dessa delar balanseras rätt kan AI bli mer än ett hjälpmedel – det kan bli en självklar del av applikationens logik.

.jpg&w=3840&q=75)